Автомобиль без водителя.

Беспилотный автомобиль – это транспортное средство, оборудованное системой автоматического управления, позволяющей автомобилю ездить без участия человека

В современных беспилотных автомобилях используются алгоритмы, на основе Байесовского метода одновременной локализации и картирования (SLAM, Simultaneous Localization And Mapping). Суть работы алгоритмов состоит в комбинировании данных с датчиков автомобиля (real-time) и данных географических карт (offline). SLAM и метод обнаружения и отслеживания движущихся объектов (DATMO, Detection And Tracking of Moving Objects), разработаны и применяются в автомобилях дочерней компании Google Waymo.

Интернет компания Google судилась с транспортной компанией Uber, по поводу воровства компанией Uber технологий у компании Google.

С 2017 года, компания Google выложила библиотеку SLAM в открытый доступ, для бесплатного использования любой сторонней компанией. Степень автоматизации управления автомобилем имеет несколько уровней. От самого минимального, когда требуется активное участие человека в управлении автомобилем, до максимального уровня, когда водителя в автомобиле вообще нет. Ниже приведем классификацию автоматизации управления по уровням.

Классификация автомобилей по уровню их автономности.

Классификация автоматизации автомобилей разработана Сообществом автомобильных инженеров (SAE) и содержит 6 уровней:

Уровень 0. Никакой автоматизации, водитель выполняет всю работу.

Уровень 1 (Hands on – помощь водителю). Водитель и система вместе управляют автомобилем. Пример: водитель рулит, а система регулирует мощность двигателя, сохраняя заданную скорость (круиз-контроль) или регулирует мощность двигателя и управляет тормозом, сохраняя заданную скорость, а при необходимости снижая, чтобы соблюдать дистанцию (адаптивный круиз-контроль). Другим примером является автоматическая парковка (Automatic Parking), когда скорость определяется водителем, а руление автоматическое.

Уровень 2 (hands off – частичная автоматизация). Система полностью управляет автомобилем, осуществляя ускорение, торможение и рулёжку. Водитель следит за ездой и готов вмешаться в любой момент, если система не может правильно отреагировать. Несмотря на название hands off, такие системы часто требуют от водителя держать руки на руле, как подтверждение готовности вмешаться.

Уровень 3 (eyes off – условная автоматизация). От водителя не требуется немедленной реакции. Он может, например, писать сообщения или смотреть фильм. Система сама реагирует на ситуации, требующие немедленных действий, таких как экстренное торможение. От водителя требуется готовность вмешаться в течение какого-то ограниченного времени, определённого производителем.

Уровень 4 (mind off – широкая автоматизация). Отличается от уровня 3 тем, что от водителя не требуется постоянного внимания. Например, он может лечь спать или покинуть место водителя. Полностью автоматическое вождение осуществляется лишь в некоторых пространственных областях (геозонах) или в некоторых ситуациях, например, в пробках. Вне таких мест или ситуаций, система способна прекратить вождение и припарковать машину, если водитель не взял управление на себя.

Уровень 5 (steering wheel optional – полная автоматизация). Никакого человеческого вмешательства не требуется.

Какие проблемы возникают при внедрении автоматизации в управление автомобилем.

Кажется, ну что может быть плохого, что технический прогресс внедряется в управление автомобилем, облегчая его, вплоть до полной ненужности водителя? Но проблемы возникают. И, причём не только научно-технического характера, а морально-этические. Именно на морально-этических проблемах, мы хотим заострить наше внимание.

Моральные проблемы.

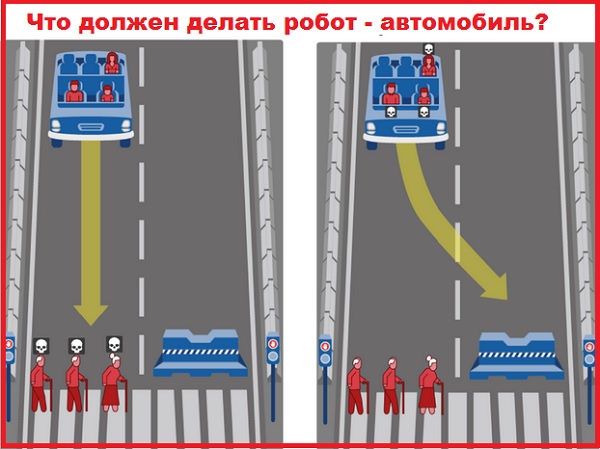

Проблема первая: как должны вести себя самоуправляемые автомобили в аварийных ситуациях, когда от решения, принятого искусственным интеллектом, зависит распределение рисков между людьми. Ожидается, что беспилотные автомобили будут попадать в такие ситуации реже, чем машины, управляемые живыми водителями. Но все же иногда, это будет происходить, а значит, искусственный интеллект должен быть готов к решению моральных проблем, таких как: “Проблемы вагонетки”, “Проблема конфликта интересов”

Моральная дилемма в духе “Проблемы вагонетки”.

Проблема вагонетки (Trolley problem ) – мысленный эксперимент в этике, впервые сформулированный в 1967 году английским философом, Филиппой Фут (Philippa Ruth Foot).

Формулировка проблемы вагонетки: Тяжелая неуправляемая вагонетка несётся по рельсам. На пути её следования находятся пять человек, привязанные к рельсам сумасшедшим философом. К счастью, вы можете переключить стрелку – и тогда вагонетка поедет по другому, запасному пути. К несчастью, на запасном пути находится один человек, также привязанный к рельсам. Каковы ваши действия?

С точки зрения математики, вопрос однозначен – пусть лучше погибнет один человек, чем пятеро. Но переключение стрелки сделает вас убийцей этого единственного человека, тогда как, если вы воздержитесь от переключения, пятеро погибнут без вашего вмешательства, то есть на вас вины не будет. У этой проблемы нет решения до настоящего времени.

Но если люди не могут однозначно решить такой вопрос, сможет ли его решить робот?

Проблема конфликта интересов

Конфликтов интересов много. Например, существует проблема конфликта интересов пассажиров и пешеходов. По мнению пешехода, беспилотные автомобили должны ставить безопасность пешеходов выше безопасности пассажиров. По мнению пассажира, всё наоборот – беспилотный автомобиль обязан спасти пассажира любой ценой.

Как именно автомобиль-робот должен решить этот конфликт – вопрос сложный. И не имеет однозначного решения. Создатели искусственного интеллекта, который находится внутри беспилотного автомобиля и управляет автомобилем, понимают, что простым набором правил типа “Трёх законов робототехники Айзека Азимова” обойтись невозможно. Посмотрим, что же это за три закона великого фантаста Айзека Азимова и почему они не пригодны для решения моральной проблемы.

Три закона робототехники Айзека Азимова

Три закона робототехники впервые сформулировал Айзек Азимов, в рассказе “Хоровод,” в 1942 году. Вот эти законы:

1. Робот не может причинить вред человеку своими действиями. Или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Если бы речь шла лишь об одном человеке, то законы робототехники Айзека Азимова помогли бы решить проблему. Но речь идет о двух людях – один внутри робота-автомобиля (пассажир), а второй снаружи (пешеход). И в этом случае, у робота автомобиля нет подходящего этического правила, кому не навредить, а кому навредить. Другого выхода нет, если одному не навредить, то другому придётся навредить.

Это свидетельствует о том, что необходимо разработать новый набор этических правил, применимых к этой сложной конфликтной ситуации для беспилотных роботов автомобилей.

Набор этических правил для беспилотных роботов-автомобилей

Этические правила должны быть достаточными для того, чтобы справляться с ситуациями, когда невозможно полностью избежать вреда, причиняемого людям, и нужно этот вред как-то “оптимизировать”, то есть, наилучшим образом распределить неизбежный вред между участниками инцидента.

Моральные и этические ценности на карте Земли

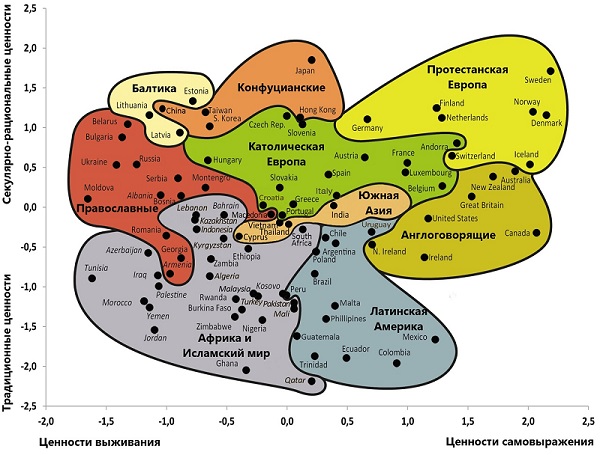

При разработке этических правил, необходимо учитывать различия в моральных нормах и в системах ценностей, реально существующих в разных странах на Земле. Результаты изучения этих различий, социологи отразили на карте Земли. Наиболее представительной является “Культурная карта мира Инглхарта-Вельцеля”(Inglehart-Welzel cultural map of the world).

На карте, по вертикальной оси, отложены Традиционные и Секулярно-рациональные ценности. Низкие значения шкалы (от 0 до -2.5) соответствуют Традиционно – Религиозным ценностям. Высокие значения (от 0 до +2.5) соответствуют Светско – Рациональным ценностям.

К традиционным ценностям относятся религия, семья, почтение к власти, абсолютные стандарты, социальный конформизм, согласие предпочитается открытым политическим конфликтам. К секулярно-рациональным ценностям относятся рациональное поведение, достижение успеха, предпочтение светского государства, низкая роль религии.

По горизонтальной оси карты отложены ценности Выживания и ценности Самовыживания. Низкие значения на горизонтальной шкале (от 0 до -2.0) соответствуют ценностям, направленным на выживание (материализм и подозрительность). Высокие значения (от 0 до +2.5) соответствуют ценностям Самовыражения и доверия. К ценностями выживания относятся экономическая и физическая безопасность, материальные ценности, нетерпимость к инакомыслию, ксенофобия, низкая оценка свободы и прав человека, готовность принять авторитаризм, покорность, склонность к вере во всемогущество науки и техники. К ценностям самовыражения относятся высокие оценки личности, свободы, прав человека, материальных благ, успеха, озабоченность экономией, равенством полов.

Социологи считают, что существует связь между ценностями самовыражения и уровнем её благосостояния.

Смотря на карту, можно сделать вывод, что Россия, с одной стороны, близка по ценностям к полюсу выживания, с другой стороны – Россия рационалистична, как Германия, Норвегия и Дания. Страны с выраженными традиционными ценностями: США, Ирландия, почти все страны Латинской Америки, Индия.

Видя такой разброс в ценностях тех или иных стран, понятно, что в чью пользу должен принять решение робот-автомобиль очень неоднозначно и во многом будет зависеть от того, по дорогам какой страны он едет. Поэтому, решение этого сложнейшего вопроса должно быть в руках международной команды профессионалов. Чтобы оценить перспективы создания универсального “морального кода” для самоуправляемых машин, международная команда социологов, психологов и специалистов по искусственному интеллекту, во главе с Иядом Рахваном, из Массачусетского технологического института, запустила сетевой проект Moral Machine.

Сетевой проект Moral Machine.

Целью проекта Моral Machine является сбор мнений людей всего мира о том, какими моральными принципами должны руководствоваться беспилотные автомобили. Сайт проекта http://moralmachine.mit.edu/ поддерживает 10 языков, имеет простой и понятный интерфейс и рассчитан на охват максимально широкой выборки респондентов. Зайдя на сайт, любой желающий может ответить на ряд вопросов.

Во всех случаях, пользователь должен указать, как следует поступить беспилотному автомобилю в критической ситуации, с участием двух групп людей (или домашних животных). Каждая из двух групп включает от 1 до 5 персонажей. В зависимости от принятого решения, одна из групп погибнет, а другая будет спасена.

Диллемы проекта Моral Machine

В каждой диллеме участвует едущий по дороге беспилотный автомобиль, у которого внезапно отказали тормоза, а перед ним кто-то переходит дорогу (либо “законно”, по правилам дорожного движения, либо “незаконно” – на красный свет). В одних диллемах, искусственный интеллект должен выбрать, какую из двух групп пешеходов сбить (а пассажирам при этом ничто не угрожает), в других – выбор осуществляется между гибелью пассажиров и пешеходов.

Персонажи, участвующие в диллемах, различаются по полу, возрасту (младенцы в колясках, дети, взрослые, пожилые), физической форме (люди с избыточным весом, обычные люди и спортсмены), социальному статусу (бездомные, обычные люди и начальники) и видовой принадлежности ( кроме людей, среди персонажей встречаются собаки и кошки). Программа генерирует дилеммы на основе алгоритма, позволяющего при анализе ответов по отдельности, оценить влияние следующих девяти факторов:

1. Действие или бездействие ( продолжать движение по прямой или свернуть).

2. Пассажиры или пешеходы (кого из них спасать).

3. Пол жертв ( спасать мужчин или женщин).

4. Физическая форма (спасать толстяков, обычных людей или спортсменов).

5. Социальный статус (спасать бездомных, простых людей или начальников).

6. Соблюдение правил (спасать ли тех, кто переходит дорогу на красный свет).

7. Возраст (спасать молодых или старых).

8. Число жертв (спасать большую или меньшую из двух групп).

9. Видовая принадлежность ( спасать людей или домашних животных).

Возможных дилемм – миллионы, поэтому вероятность того, что пользователь дважды столкнётся с одной и той же задачей, пренебрежимо мала.

Проблема универсальной морали глазами Moral Machine

В ходе эксперимента, Moral Machine были собраны мнения почти 40 миллионов человек, при решении отдельных дилемм. Люди, ответившие на вопросы, проживают в 233 странах. Большинство участников заполнили анкету, в которой указали свой возраст, пол, образование, ежегодный доход, отношение к религии и политические взгляды.

Накопленные данные позволили сравнить результаты по разным странам и выделить страны со сходными моральными установками. В анализе было учтено 130 стран с числом респондентов не менее 100. Получившееся дерево сходства стран по моральным установкам, имеет много общего с упомянутой” культурной картой мира,” Инглхарта-Вельцеля.

Все страны объединились в три большие группы, условно обозначенные, как Западная, Восточная и Южная.

Западная группа включает США, Канаду и многие европейские страны (католические, протестантские и православные). Внутри Западной группы чётко обозначились такие ветви, как: англоговорящие страны, скандинавские с Германией, Швейцарией и Австрией.

В Восточной группе преобладают страны, либо с конфуцианской, либо с мусульманской традицией.

Южная группа состоит из двух ветвей: в первую ветвь включены страны Латинской Америки, а во вторую Франция и ряд стран, находившихся в прошлом под французским влиянием.

Люди из различных групп, имеют разные представления о том, как должны вести себя беспилотные машины в критических ситуациях. Например, в Южной группе преобладают идеи о необходимости спасать прежде всего детей и женщин, тогда как жители стран из Восточной группы, отдают предпочтение законопослушным пешеходам и не ставят жизнь молодых, намного выше жизни старших.

Приведём наиболее значимые выводы из анализа всех заполненных анкет.

1. Практически во всех странах, люди склонны ставить жизнь людей намного выше жизни домашних животных.

2. Важно минимизировать число жертв и, в первую очередь спасать детей, молодых, законопослушных (переходящих дорогу на зелёный свет) и высокостатусных людей.

Тот факт, что полученные результаты хорошо согласуются с данными Всемирного обзора ценностей и разумным образом коррелируют с социоэкономическими показателями, свидетельствуют в пользу осмысленности и значимости этих результатов. Но само исследование подвергается критике, из-за очевидных его недостатков.

Недостатки исследования.

1. Беспрецедентно по своим масштабам исследование, обременено рядом недостатков. В первую очередь, вызывает недоверие уровень репрезентативности, для слабо развитых в экономическом отношении стран. В этих странах, типичный житель может не иметь доступа к Интернету, чтобы ответить на вопросы.

2. Очень трудно, а то и невозможно собрать и обработать данные по сотням стран, соблюдая все требования, предъявляемые к репрезентативности выборок.

3. Заложенные в исследование упрощения, ограничивают практическую применимость полученных выводов. Укажем на некоторые ограничения (упрощения):

– во всех моральных дилеммах было точно известно, “кто есть кто” (про мальчиков было точно известно, что они мальчики, а про толстяков, что они – толстяки);

– результат любого решения, тоже был известен заранее со стопроцентной точностью (одна группа персонажей точно умрет, другая точно выживет).

В реальной жизни, беспилотным машинам роботам придется иметь дело не с точным априорным знанием, а с приблизительными оценками вероятностей.

Дискуссия продолжается.

К результатам, полученным в этом масштабном опросе, авторы предлагают относиться, как к отправной точке, для широкой международной дискуссии.

Ещё ни одному роботу-машине, не было позволено самостоятельно, без непосредственного контроля со стороны человека, за доли секунды, принимать решения о жизни и смерти людей.

Но беспилотные автомобили скоро появятся на дорогах. Аварии с их участием и с человеческими жертвами неизбежны. Хотя анализ данных показал, что беспилотные автомобили будут попадать в аварийные ситуации реже, чем машины, управляемые живыми водителями.

Это весьма обнадёживающий вывод. Но все же аварийные ситуации обязательно будут происходить, а значит, искусственный интеллект должен быть готов к решению моральных диллем в духе “Проблемы вагонетки”. А при разработке “морального закона” для самоуправляемых машин, необходимо учитывать, помимо прочего, данные о изменчивости этических норм в разных странах Земли.